자동화 실험

나만의 뉴스 큐레이터 – RSS 기반 키워드 뉴스 자동 수집 실험

오토마스터

2025. 4. 21. 20:21

반응형

“읽고 싶은 뉴스만 골라주는 나만의 AI 뉴스봇, 만들 수 없을까?”

🧠 시작하며 – 뉴스는 많은데, 정작 보고 싶은 건 없다?

오늘도 뉴스는 넘쳐납니다.

포털 메인, 유튜브, SNS, 실시간 검색어…

정보의 홍수 속에서 '필요한 뉴스'만 걸러보는 건 생각보다 힘든 일입니다.

그래서 이번 AutoT 블로그 실험 주제는

“RSS와 키워드를 활용해,

나만의 뉴스 큐레이터를 만들어보자”입니다.

🧪 실험 목표

- 키워드 기반으로 내가 관심 있는 뉴스만 수집하기

- 매일 정해진 시간에 자동으로 수집 & 정리

- 나중에는 슬랙, 메일, 텔레그램, 노션 등 연동 확장도 가능

🔧 사용 도구

| 도구 | 설명 |

| Python | 전체 로직 처리 |

| feedparser | RSS 피드 수집용 라이브러리 |

| schedule | 자동 실행 스케줄러 |

| re | 키워드 매칭(정규식 기반) |

| datetime | 날짜별 정리용 |

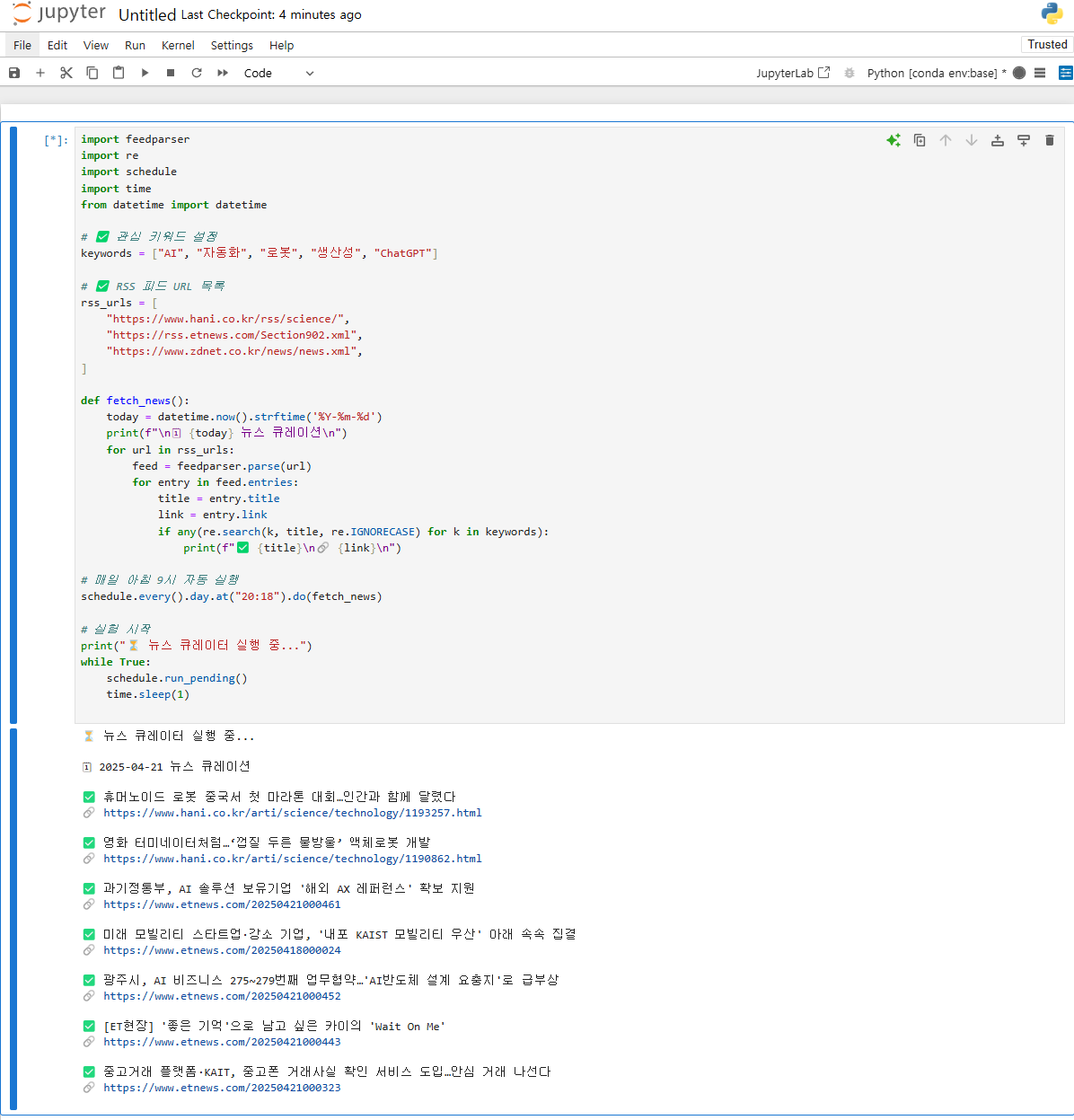

🗂 실험 코드 요약

import feedparser

import re

import schedule

import time

from datetime import datetime

# ✅ 관심 키워드 설정

keywords = ["AI", "자동화", "로봇", "생산성", "ChatGPT"]

# ✅ RSS 피드 URL 목록

rss_urls = [

"https://www.hani.co.kr/rss/science/",

"https://rss.etnews.com/Section902.xml",

"https://www.zdnet.co.kr/news/news.xml",

]

def fetch_news():

today = datetime.now().strftime('%Y-%m-%d')

print(f"\n🗓 {today} 뉴스 큐레이션\n")

for url in rss_urls:

feed = feedparser.parse(url)

for entry in feed.entries:

title = entry.title

link = entry.link

if any(re.search(k, title, re.IGNORECASE) for k in keywords):

print(f"✅ {title}\n🔗 {link}\n")

# 매일 아침 9시 자동 실행 (돌리고 싶은 시간으로 변경)

schedule.every().day.at("09:00").do(fetch_news)

# 실험 시작

print("⏳ 뉴스 큐레이터 실행 중...")

while True:

schedule.run_pending()

time.sleep(1)

주피터 노트북 돌린 결과 잘 된다~

📌 핵심 기능 설명

- feedparser: 각 언론사의 RSS를 읽어 뉴스 제목/링크 추출

- keywords: 원하는 주제만 수집

- schedule: 매일 지정 시간 자동 실행

- 확장 예시:

- 슬랙 알림 → slack_sdk

- 이메일 발송 → smtplib

- 노션에 정리 → notion_client

💡 실전 적용 팁

- 키워드 리스트에 관심 있는 분야를 다양하게 추가

예) "챗GPT", "프롬프트 엔지니어링", "생성형 AI" 등 - RSS 주소는 다양하게 활용 가능

- 네이버 뉴스 RSS

- 구글 뉴스 RSS 생성기 활용

- [IT 전문지, 블로그, 데이터 저널리즘 채널 추가 가능]

- 정리 결과를 텍스트 파일이나 노션 등에 저장하면 보관성 Good

🎯 실험 결과 – 매일 1분이면 핵심 뉴스만 체크 가능

이 자동화를 돌린 지 5일.

매일 아침 내가 설정한 키워드 중심의 기사만 정리되어 출력되니까

뉴스에 소비하는 시간이 눈에 띄게 줄었고,

쓸데없는 정보 피로도도 줄었다.

이제는 '모든 뉴스 보기'가 아니라

‘필요한 뉴스만 보기’가 가능해진다.

반응형